一种视频精细化方法,包括时间上的插帧和空间上的超分。需要文本提示输入,对原画面有较大修改,但可以看出明显的效果提升。

Method

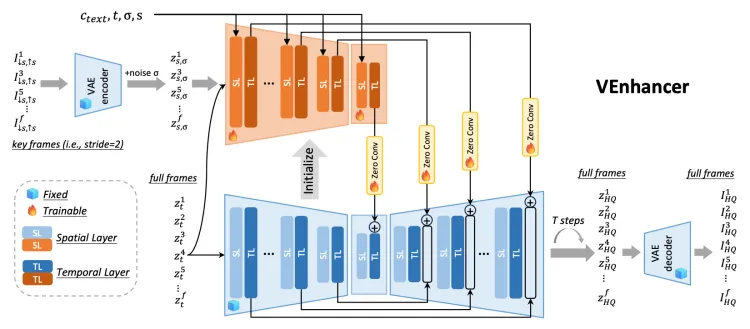

VEnhancer遵循ControlNet,基于MS-Vid2Vid-XL(Video-to-Video)模型,并复制多帧编码器的体系结构和权重以及预训练的视频扩散模型的中间块,构建可训练的条件网络。

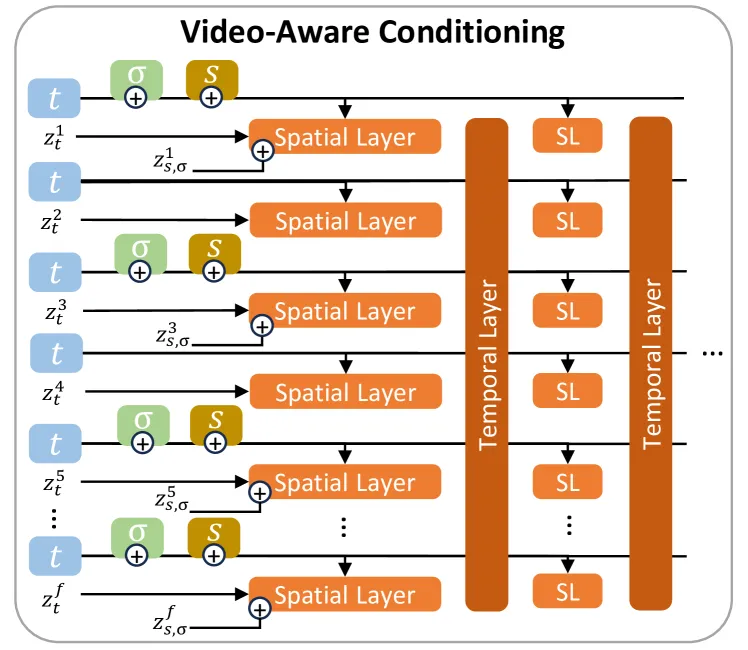

此视频ControlNet接受低分辨率关键帧的编码以及全部帧的编码作为输入。将缩放系数s、加噪强度σ与时间步t共同嵌入,在全部帧编码的加噪隐变量上去噪(加噪强度一定程度上可控),最终输出新的视频。

遵循ControlNet的训练方式,从生成器中复制多帧编码器和中间块的权重作为可训练的条件控制网络。

条件网络设计: 输入包括: 低分辨率关键帧,全帧的noisy latents,输出多尺度时间相干的视频特征。与原始controlnet的区别在于,空间卷积或注意力层后具有时间卷积或注意力层,并且多帧控制信号通过时间层对齐。

构建训练数据方式:时空数据增强,随机采样不同的下采样因子(1x到8x)、不同数量的跳帧(0到7)以及噪声增强中的不同噪声级别(Cascaded Diffusion Models for High Fidelity Image Generation、IMAGEN VIDEO)。时空数据增广,使用真实视频而非合成视频进行训练。

视频感知conditioning:可以实现跨帧的不同条件。

Comments | NOTHING